Tính năng quét hình ảnh và tin nhắn của người dùng để xác định lạm dụng tình dục trẻ em của Apple ngày càng thu hút sự chú ý và số lượng các tổ chức và cá nhân phản đối cũng đang tăng lên. Trước những lo ngại của người dùng về việc lạm dụng công nghệ, chỉ một câu nói "hãy tin chúng tôi" của Apple rõ ràng là không thể thuyết phục được công chúng.

Ngày 16/2/2016, Apple đã nhận được yêu cầu dài hỗ trợ mở khóa chiếc điện thoại từ tòa án. FBI đã cố gắng mở khóa iPhone của nghi phạm trong vụ xả súng nhưng không thành công, vì vậy họ đã yêu cầu Apple phát triển một phiên bản iOS đặc biệt: có thể nhập mật khẩu không giới hạn số lần cho đến khi mở khóa thành công điện thoại của nghi phạm.

Điều đáng ngạc nhiên là Tim Cook đã từ chối yêu cầu những người thực thi pháp luật, "Việc xây dựng một phiên bản iOS có thể qua mặt bảo mật chắc chắn đang mở ra một "cửa sau".

Mặc dù chính phủ lập luận rằng họ có thể hạn chế được tình trạng này, nhưng trên thực tế, việc kiểm soát như vậy không thể đảm bảo 100%. "Apple dường như đứng về phía những kẻ khủng bố, nhưng hãng đã thành công thiết lập hình ảnh bảo vệ quyền riêng tư của người dùng trong mắt nhiều người".

|

| Ảnh: Zhihu |

Tuy nhiên, điều bất ngờ là thái độ của Apple đối với "quyền riêng tư" lại thay đổi nhanh chóng như vậy.

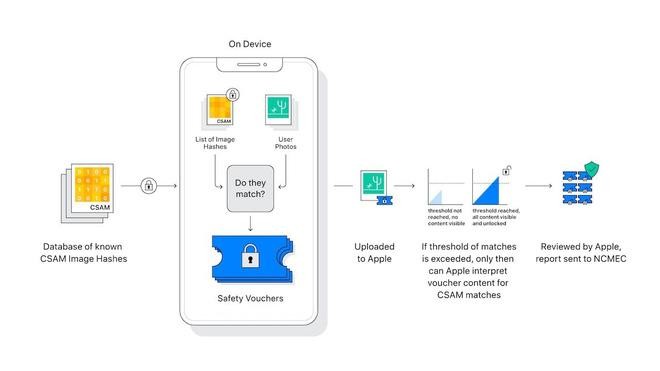

Mới đây, Apple đã đưa ra 3 chính sách mới về bảo vệ chống xâm hại tình dục trẻ em, một trong những điều đáng lo ngại nhất là ảnh của người dùng sẽ trải qua quá trình băm (hash) trên thiết bị trước khi tải lên iCloud Photos nhằm tìm kiếm các dấu hiệu tài liệu lạm dụng tình dục trẻ em.

Những chính sách chưa áp dụng vào thực tế này đã gây ra một cơn địa chấn mạnh mẽ trong dư luận. Hơn 6000 tổ chức và cá nhân đã khởi xướng một lá thư chung trên GitHub, "Mặc dù xuất phát điểm để chống lạm dụng trẻ em là hoàn toàn có chủ đích tốt, nhưng hệ thống và thuật toán thông minh đằng sau lại tạo thêm một "cửa sau" cho hệ thống của Apple, có thể xâm phạm quyền riêng tư cá nhân của tất cả người dùng Apple".

Những người nổi tiếng ký vào thư ngỏ này hiện có chuyên gia mật mã học Matthew Green và cựu tình báo viên Edward Snowden. Edward cảnh báo: "Hôm nay bạn có thể quét ảnh lạm dụng trẻ em, và ngày mai bạn có thể quét bất cứ thứ gì... "

"Tôi chụp một số hình ảnh trong khi tắm cho con, liệu tôi có bị đánh dấu là lạm dụng tình dục trẻ con không?"

Apple tiết lộ rằng họ đã phát triển một thuật toán mã hóa để quét album ảnh của người dùng nhằm phát hiện ra CSAM (Nội dung lạm dụng tình dục trẻ em). Thuật toán này được gọi là "NeuralHash", là một thuật toán sử dụng các giá trị băm để đối sánh.

Giá trị băm thường là một chuỗi số dài, có thể hiểu đơn giản là DNA của một phần dữ liệu (một tệp hoặc một chuỗi), hoặc một thẻ ID. Nó được so sánh với DNA vì giá trị băm của mỗi tệp là duy nhất. Dựa trên đặc điểm này, giá trị băm thường được sử dụng để xác định xem hai tệp có giống nhau hay không.

Thuật toán hiện đang được đào tạo trên "200.000 hình ảnh" được cung cấp bởi NCMEC (Trung tâm Quốc gia Bảo vệ Trẻ em Mất tích và Bị bóc lột, một tổ chức bảo vệ trẻ em do Quốc hội Mỹ thành lập) và nó sẽ chính thức ra mắt cùng với các hệ thống mới như iOS 15 và macOS Monterey. Apple cho biết, tính năng "băm" ảnh người dùng này sẽ được triển khai lần đầu tiên tại Mỹ.

|

| Quá trình xử lý dữ liệu để xác định hình ảnh nhạy cảm của trẻ em trên máy người dùng. Ảnh: Apple |

Nguyên tắc tương tự như so sánh dấu vân tay. Nếu hình ảnh có một số điểm trùng khớp nhất định với cơ sở dữ liệu lạm dụng tình dục trẻ em hiện có, Apple sẽ thực hiện quá trình kiểm tra thủ công để xem liệu ảnh được đề cập có liên quan đến lạm dụng tình dục trẻ em hay không, sau đó sẽ thực hiện các biện pháp như gắn cờ và cảnh báo cho NCMEC.

Một số cư dân mạng bày tỏ lo ngại: "Tôi chụp một số bức ảnh trong khi giúp con tôi tắm, liệu tôi có bị liệt vào đối tượng lạm dụng trẻ em?" Apple giải thích rằng họ không thể trực tiếp xem ảnh của người dùng và việc so sánh dựa trên giá trị băm của ảnh. Công ty nhấn mạnh rằng họ không "tìm hiểu bất cứ hình ảnh nào không khớp với kho hình ảnh trong cơ sở dữ liệu CSAM".

Apple cũng cho biết rằng nếu người dùng vô hiệu hóa iCloud, ảnh được lưu trữ cục bộ sẽ không được quét. Đồng thời, những bức ảnh mà người dùng đã tải lên iCloud cũng sẽ được so sánh.

Việc quét các nội dung bất hợp pháp như vậy không phải do Apple thực hiện đầu tiên. Facebook, Twitter, Reddit và các công ty khác cũng sẽ quét các tệp của người dùng dựa trên thư viện băm. Họ thường sử dụng một công cụ do Microsoft PhotoDNA phát triển, quét các tệp của người dùng được lưu trữ trên máy chủ. Theo luật pháp Mỹ, một khi các công ty này phát hiện ra nội dung lạm dụng tình dục trẻ em, họ có nghĩa vụ báo cáo với Trung tâm Bảo vệ Trẻ em.

Sự khác biệt giữa Apple và các công ty này là Apple quét và so sánh ngay trên thiết bị của người dùng.

Ngoài ra, Apple sẽ tung ra hai bản cập nhật bảo vệ chống lạm dụng tình dục trẻ em. Một là cung cấp tài nguyên trợ giúp và thông tin nhanh chóng trong Siri và các chức năng tìm kiếm, và hai là thêm tính năng nhận dạng hình ảnh sử dụng máy học trên thiết bị để bảo vệ người dưới 17 tuổi xem hình ảnh khiêu dâm trong Messages. Phụ huynh có thể chọn nhận thông báo khi trẻ em dưới 13 tuổi gửi hoặc nhận nội dung đó. Tuy nhiên, hai tính năng mới cũng đối mặt với rất nhiều chỉ trích.

|

| Nếu người dùng cấu hình chức năng chia sẻ gia đình trong iOS, cuộc trò chuyện của trẻ vị thành niên trong ứng dụng nhắn tin sẽ được giám sát dựa trên công nghệ máy học. Ảnh: Apple |

Nếu một người dùng vị thành niên gửi và nhận các bức ảnh khiêu dâm trong iMessage, hệ thống của Apple cũng sẽ đưa ra phán đoán sau khi quét cục bộ và xử lý. Nhưng Apple tuyên bố rằng cha mẹ không thể trực tiếp xem những gì con họ đang xem và quá trình này không vi phạm cam kết của họ về giao thức mã hóa end-to-end của iMessage.

Làn sóng phản đối đang tiếp tục

Ông Snowden đã phàn nàn về Apple trên Twitter: "Apple vào năm 2016: Chúng tôi không cho phép FBI xem điện thoại của những kẻ khủng bố đã chết chỉ để bảo vệ quyền riêng tư của bạn; Apple vào năm 2021: Chúng tôi sẽ sử dụng thuật toán mã hóa để kiểm tra album ảnh và iCloud của bạn, ngoài việc gọi cảnh sát, chúng tôi cũng sẽ báo cho bố mẹ bạn biết".

Các gã khổng lồ công nghệ cũng lên tiếng đổ lỗi cho Apple. Giám đốc WhatsApp Will Cathcart nói rằng các nền tảng của Facebook sẽ không áp dụng cách tiếp cận của Apple và họ dựa vào người dùng để báo cáo nội dung lạm dụng tình dục trẻ em.

"Đây là một hệ thống giám sát do Apple thiết lập và vận hành, có thể được sử dụng để quét nội dung riêng tư rất dễ dàng cho bất cứ điều gì họ hoặc chính phủ quyết định kiểm soát".

"Về hợp tác với các cơ quan quản lý, mặc dù chúng ta thấy rằng Apple đã từng từ chối lệnh của FBI, nhưng nhìn chung, Apple vẫn hỗ trợ giám sát các hoạt động theo khuôn khổ pháp lý của nhiều khu vực khác nhau", Cathcart nói.

|

| Ảnh: Zhihu |

Học giả Matthew Green của Đại học Johns Hopkins đặt câu hỏi, kho ảnh iCloud hiện tại không sử dụng thuật toán mã hóa end-to-end, tại sao lại phải thiết kế một cơ chế phức tạp như vậy?

Một giả định tốt là Apple cũng sẽ áp dụng mã hóa end-to-end trong việc tải ảnh lên; tuy nhiên, cũng có thể xảy ra một giả định xấu - Apple đang cố gắng mở rộng ranh giới quy định.

Tổ chức Tiền tuyến Điện tử EFF (Electronic Frontier Foundation) nói rằng hoạt động quét ảnh của Apple trên thiết bị của người dùng hoàn toàn phủ nhận ý nghĩa của "mã hóa end-to-end" vì người dùng khó xác minh những gì Apple "đã quét" và "đã chặn". Máy chủ có thể cũng sử dụng phương pháp này để thu được giá trị băm của một lượng lớn nội dung được truyền và thực hiện phân tích dữ liệu. "Cửa hậu nhỏ nhất cũng là một cửa hậu", EFF viết.

Nhà phân tích công nghiệp Ben Thompson đã viết trên blog của mình, "Bạn có thể tắt tính năng đồng bộ hóa iCloud, nhưng mấu chốt là người dùng Apple rất khó thoát khỏi tính năng đồng bộ hóa đám mây. Việc hợp tác sản phẩm trong hệ sinh thái Apple chỉ có thể thực hiện được thông qua kết nối iCloud. Điều thực sự đáng thất vọng là Apple bị ám ảnh bởi quan điểm đặc biệt của họ về quyền riêng tư. Cuối cùng, người dùng không thể tin rằng thiết bị họ mua thực sự thuộc về họ".

Sự tự vệ của Apple

Tuần trước, Phó Chủ tịch Phần mềm của Apple Sebastien Marineau-Mes đã viết một bản ghi nhớ nội bộ, "Một số người hiểu lầm về cách thức hoạt động của các chức năng này" và công ty sẽ cung cấp nhiều giải thích hơn trong tương lai.

Từ quan điểm nội bộ, ba chính sách mới của Apple không chỉ cung cấp các công cụ để bảo vệ trẻ em mà còn duy trì cam kết của Apple đối với quyền riêng tư của người dùng. "Chúng tôi biết rằng tương lai sẽ tràn ngập những âm thanh khắc nghiệt của một số ít người, nhưng tiếng nói của chúng tôi sẽ lấn át họ".

"Công nghệ này bị giới hạn trong việc phát hiện nội dung bất hợp pháp được lưu trữ trong iCloud. Chúng tôi sẽ không đồng ý với bất kỳ yêu cầu nào của chính phủ". Apple cũng cho biết trong một tài liệu khác, "Chúng tôi sẽ từ chối bất kỳ yêu cầu nào như vậy".

Nhưng sự việc vẫn tiếp tục lên đi theo chiều hướng xấu, số tổ chức, cá nhân cùng phản đối vẫn ngày một tăng. Đối với những lo ngại của người dùng về việc lạm dụng công nghệ, việc Apple sử dụng cụm từ "hãy tin tưởng chúng tôi" rõ ràng không thể thuyết phục được công chúng.

|

Một số người dùng ký vào bức thư ngỏ đã đặt câu hỏi, "Apple không phải là cơ quan thực thi pháp luật, nhưng quá trình quét đã tạo ra "giả định tội lỗi" cho tất cả người dùng". Ảnh: appleprivacyletter.com |

Không ai không ủng hộ việc bảo vệ trẻ em. Theo Hiệp hội Trẻ em Quốc gia Mỹ, trung bình cứ 5 trẻ em thì có 1 trẻ bị quấy rối tình dục trên Internet. Theo dữ liệu từ Trung tâm Bảo vệ Tấn công Tình dục Trẻ em, 30% các vụ hành hung chưa từng được báo cáo. Phạm vi xâm hại tình dục trẻ em rất rộng, mặt chìm gấp nhiều lần mặt nổi.

Nhưng tính năng quét quyền riêng tư quá dễ dàng khiến công chúng hoang mang, ngay cả khi đó là tính năng quét quyền riêng tư được mã hóa, ngay cả khi nó được Apple phát hành - công ty vốn nhấn mạnh đến việc bảo vệ quyền riêng tư trong mọi cuộc họp báo.

Một số người dùng bày tỏ sự lo lắng của họ: "Điều này giống như việc lắp đặt camera trong nhà để tránh tôi mắc lỗi". Theo quan điểm của họ, các công ty thương mại không có quyền "kiểm duyệt" dữ liệu người dùng.

Rõ ràng, ngay cả khi một vấn đề có thể được giải quyết bằng công nghệ, ngay cả khi nó có điểm khởi đầu của công lý, nó vẫn phải đối mặt với thách thức rất lớn về sự tin tưởng và ủy quyền.

Theo Geek Park