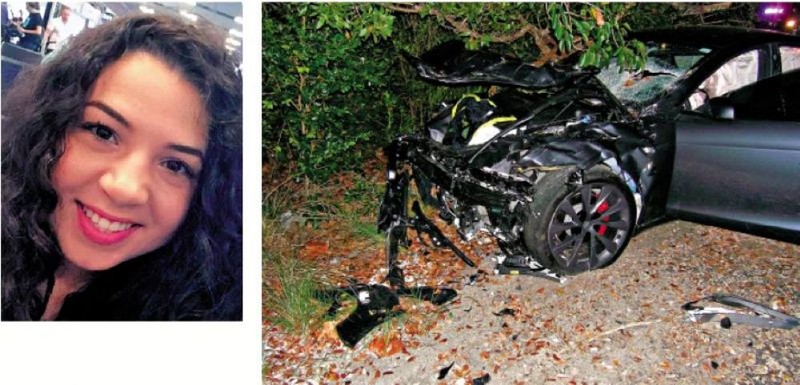

Hôm 1/8 vừa qua, bồi thẩm đoàn gồm 8 người tòa án ở Miami bang Florida, Mỹ đã ra phán quyết yêu cầu công ty Tesla phải chịu một phần trách nhiệm trong vụ tai nạn chết người xảy ra năm 2019 liên quan đến một chiếc Tesla Model S có trang bị hệ thống tự lái, và buộc công ty phải bồi thường khoản tiền 243 triệu USD cho gia đình nữ nạn nhân thiệt mạng cùng một người bị thương.

Trong một tuyên bố đưa ra sau khi tòa phán quyết, Tesla nói: “Phán quyết ngày hôm nay là sai lầm, sẽ cản trở sự an toàn của ngành ô tô và đe dọa nỗ lực của Tesla cũng như toàn ngành trong việc phát triển các công nghệ cứu mạng. Nguyên đơn đã dựng lên một câu chuyện để đổ lỗi cho chiếc xe, trong khi ngay từ đầu người lái đã thừa nhận và chấp nhận trách nhiệm của mình”. Elon Musk cho biết sẽ tiếp tục kháng cáo.

Tai nạn do xe có hệ thống tự lái, nhà sản xuất phải bồi thường – nghe có vẻ hiển nhiên. Nhưng xem xét kỹ vụ việc, Tesla lần này dường như có phần oan ức.

Tài xế có lỗi chính, nhưng Tesla cũng không “vô can”

Theo thông tin từ truyền thông Mỹ, George McGe – tài xế điều khiển chiếc Tesla - sử dụng hệ thống Enhanced Autopilot có tính năng hỗ trợ lái xe nâng cao của Tesla, không phải là hệ thống tự lái hoàn toàn (Full Self-Driving – FSD), mà chỉ là hệ thống hỗ trợ người lái cấp độ 2 (Level 2) theo tiêu chuẩn phân loại của SAE (Hiệp hội Kỹ sư ô tô).

Trong lúc lái xe, tài xế đã cúi xuống nhặt điện thoại rơi dưới sàn xe, bỏ mặc cho hệ thống tự lái. Chính vào khoảnh khắc đó, chiếc Tesla Model S không nhận biết được biển dừng (STOP) và đèn đỏ ở ngã tư phía trước, thậm chí còn tăng tốc lên 90km/h rồi đâm vào một chiếc SUV đang đỗ ven đường. Hậu quả là nữ chủ xe SUV thiệt mạng tại chỗ, bạn trai của nạn nhân cũng bị thương nặng.

Ở góc độ cá nhân, người ta cho rằng hành vi của tài xế đã rõ ràng cấu thành lỗi lái xe nguy hiểm. Dù công nghệ tự lái khi đó đạt đến cấp độ nào, thì việc đi qua ngã tư đều đòi hỏi tài xế phải quan sát kỹ và giảm tốc – huống chi ở đây còn có cả biển báo dừng và giảm tốc, vậy mà tài xế đã phó mặc toàn bộ cho hệ thống Enhanced Autopilot điều khiển xe, dẫn đến hậu quả nghiêm trọng.

Tài xế cũng thừa nhận tại tòa rằng việc ông ta cúi xuống nhặt điện thoại khi đang lái xe là hành vi nguy hiểm và ông phải chịu trách nhiệm.

Vậy tại sao bồi thẩm đoàn vẫn quy trách nhiệm cho Tesla? Lý do rất đơn giản: trước thời điểm xảy ra tai nạn, hệ thống Enhanced Autopilot không hề phanh, né tránh hay cảnh báo va chạm. Dù luật sư của Tesla giải thích rằng tài xế vẫn đang đạp chân ga – khiến một số tính năng phanh bị vô hiệu – và xe chạy vượt tốc độ giới hạn của hệ thống (45 km/h), nhưng lập luận này khó thuyết phục.

Bởi lẽ nếu việc đạp chân ga có thể khiến hệ thống không thể phanh, thì liệu có còn xứng đáng gọi là “tự động lái” không? Nói cách khác, Enhanced Autopilot đáng lẽ phải giúp tài xế tránh tai nạn, nhưng không những không hỗ trợ gì, mà còn khiến tài xế thêm mất tập trung.

Enhanced Autopilot: không phải tự động lái thực sự

Trên thực tế, Enhanced Autopilot của Tesla chỉ là hệ thống hỗ trợ lái, thậm chí chưa đạt đến cấp L2, nên càng không thể gọi là “tự động lái”.

Công nghệ tự lái được chia theo chuẩn 6 cấp độ từ L0 đến L5:

L0–L2: chỉ là hỗ trợ lái, tài xế vẫn phải hoàn toàn chịu trách nhiệm.

L3: Tự động hóa có điều kiện (Conditional Automation) mới được coi là "tự động lái", xe có thể điều khiển trong một số điều kiện nhất định nhưng tài xế vẫn cần cảnh giác để can thiệp khi cần.

L4: Tự động hóa cao (High Automation) gần như hoàn toàn tự động, xe có thể hoạt động độc lập trong phạm vi nhất định, trách nhiệm khi có tai nạn phần lớn thuộc về nhà sản xuất.

L5: Tự động hóa hoàn toàn (Full Automation). Xe có thể tự vận hành trong mọi điều kiện giao thông và thời tiết, không cần người điều khiển hay can thiệp. Xe không có vô lăng hay bàn đạp. Hiện tạ chưa có xe cấp độ L5 nào được thương mại hóa rộng rãi.

Vấn đề ở đây là Tesla đã từng quảng bá Enhanced Autopilot theo cách khiến người dùng hiểu nhầm rằng đây là L3 hoặc cao hơn, tức có thể tự điều khiển hoàn toàn – trong khi thực tế không phải vậy.

Theo trang TeslaDeaths.com, ít nhất đã có 58 vụ tử vong liên quan đến việc tài xế kích hoạt Autopilot mà không giám sát đúng cách.

Chính vì vậy, sau này Tesla đã rất cẩn trọng khi quảng bá hệ thống FSD (Full Self-Driving), luôn nhấn mạnh rằng chỉ là hỗ trợ lái cấp L2, tức tài xế vẫn phải hoàn toàn chịu trách nhiệm.

Sáu năm trôi qua, hệ thống tự lái của Tesla vẫn chưa chứng minh được mình.

Quay lại vụ việc, đây là tai nạn từ 6 năm trước – khi công nghệ còn non nớt, việc đánh giá Tesla ngày đó bằng tiêu chuẩn ngày nay cũng phần nào là thiếu công bằng.

Thế nhưng, Tesla ngày nay thì sao? Các thế hệ Autopilot và FSD hiện nay vẫn chưa thể khiến người dùng yên tâm. Tại Mỹ, nhiều người vẫn phàn nàn rằng FSD chưa đủ tin cậy. Năm 2023, một tai nạn nghiêm trọng xảy ra do xe bị mất kiểm soát khi đang kích hoạt FSD đã khiến toàn bộ người trên xe tử vong – điều này cho thấy FSD vẫn chưa đạt chuẩn tự động lái thực sự.

Vụ kiện này cho thấy một điều then chốt: "trí tuệ nhân tạo hỗ trợ" không đồng nghĩa với "tự động hóa hoàn toàn", và việc truyền thông sai lệch về mức độ tự động của công nghệ có thể dẫn đến hậu quả nghiêm trọng – cả với người dùng lẫn nhà sản xuất.

Phân tích của chuyên gia cho rằng, phán quyết này có thể gây ra ảnh hưởng sâu rộng đối với Tesla cũng như toàn bộ ngành công nghiệp xe tự lái, đồng thời sẽ cản trở dịch vụ taxi không người lái (Robotaxi) của Tesla và việc phổ cập công nghệ tự lái.

Giá cổ phiếu của Tesla vào ngày 1/8 đã giảm 1,8%, nâng tổng mức giảm từ đầu năm đến nay lên 25,06%, thuộc nhóm giảm mạnh nhất trong số các công ty công nghệ lớn trên thị trường chứng khoán Mỹ.

Tesla lần này có thể “oan ức”, nhưng cũng là bài học đắt giá về trách nhiệm, minh bạch, và giới hạn công nghệ trong kỷ nguyên xe thông minh.

Trung Quốc chấn chỉnh quảng cáo sai về “xe tự lái”, khẳng định trách nhiệm của con người